在佐治亚州亚特兰大举行的 SC24 大会上,SK hynix正在展示其面向 AI 和 HPC 的高级内存解决方案。

自 1988 年以来,该年度活动由计算机协会和 IEEE 计算机学会组织,展示了 HPC、网络、存储和数据分析方面的最新发展。

SK海力士已连续第二年回归,通过展示内存产品以及有关AI和HPC技术的深刻演讲,巩固了其在AI内存的领导地位。根据会议的“HPC Creates”主题(强调超级计算对各个行业的影响),该公司展示了其内存解决方案如何推动不同领域的进步。

展示适用于 AI 和 HPC 的高级内存解决方案

在其 展位上,该公司正在演示和展示一系列为 AI 和 HPC 量身定制的产品。正在演示的产品包括其 CMM(CXL (1) 内存模块)-DDR5 (2)、AiMX (3) 加速卡和 Niagara 2.0 等。

CMM-DDR5 与采用至强 6 处理器的服务器平台的现场演示展示了 CXL 内存技术如何在各种使用模式下加速 AI 工作负载。此外,展位的参观者可以了解采用 EDSFF (4) 的最新 CMM-DDR5 产品,该产品在 TCO (5) 和性能方面都有所改进。

另一个现场演示是将 AiMX 集成在华擎机架式服务器中,以运行 Meta 的 Llama 3 70B,这是一个具有 700 亿个参数的大型语言模型 (LLM)。该演示突出了 AiMX 在处理大型数据集方面的效率,同时实现了高性能和低功耗,解决了 LLM 中注意力层 (6) 带来的计算负载挑战。

正在演示的其他技术包括 Niagara 2.0。CXL 池内存解决方案支持数据共享,以最大限度地减少 AI 推理期间的 GPU 内存短缺 (7),使其适用于 LLM 模型。 该公司还展示了具有接近内存处理 (NMP) (8) 的 HBM ,它加速了 HPC 中常见的间接内存访问 (9)。该解决方案由洛斯阿拉莫斯国家实验室 (LANL) 开发,突出了基于 NMP 的 HBM 在推动下一代技术方面的潜力。

另一个演示展示了 SK 海力士更新的 OCS (10) 解决方案,与 SC23 上展示的迭代相比,该解决方案在实际 HPC 工作负载的分析性能方面有了显著改进。OCS 与 LANL 共同开发,通过使存储能够独立分析数据、减少不必要的数据移动并提高资源效率,解决了传统 HPC 系统中的性能问题。此外,该公司还演示了一个检查点卸载 SSD (11) 原型,该原型通过提高性能和可扩展性来提高 LLM 训练资源的利用率。

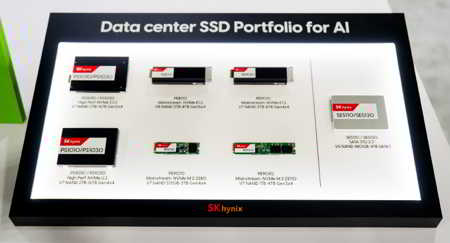

除了进行产品演示外,SK海力士还展示了强大的数据中心解决方案阵容,包括HBM3E(12)。5th–Gen HBM 提供高速数据处理、最佳散热和高容量,使其成为 AI 应用必不可少的。除了 HBM3E 之外,该公司还有 Rapid DDR5 RDIMM 和 MCR DIMM 产品,这些产品专为高性能服务器中的 AI 计算量身定制。包括第 5 代 PS1010 和 PEB110 在内的企业级 SSD (eSSD) 也在展会上展出。这些 SSD 解决方案提供超快的 RW 速度,对于在大规模环境中加速 AI 训练和推理至关重要。

通过专家演讲突出记忆的潜力

Jongryool Kim 介绍 HPC 和 AI 系统的内存和存储方面的进步

在会议期间,人工智能系统基础设施研究总监Jongryool Kim发表了题为“内存和存储:HPC/AI的力量”的演讲,强调了HPC和AI系统的内存需求。他专注于 2 项关键进步,包括使用 CXL、HBM 和 SSD 的近数据处理技术来提高性能,以及 CXL 池内存以实现更好的系统数据共享。

Jeoungahn Park 在 OCS 上发表演讲

可持续计算团队的技术负责人 Jeoungahn Park 也上台发表了题为“利用开放标准化 OCS 促进 HPC 数据分析”的演讲。Park 解释了 OCS 如何使存储能够自动识别和分析数据,从而加速 HPC 中的数据分析。他添加了 OCS 如何提高资源效率并与现有分析系统集成,以及如何在实际 HPC 应用程序中验证其分析性能。

在 SC24 上,SK 海力士巩固了其作为内存解决方案先驱的地位,这些解决方案正在推动 AI 和 HPC 技术的创新。展望未来,该公司将在合作伙伴的支持下继续突破技术界限,以塑造 AI 和 HPC 的未来。

(1) Compute Express Link (CXL)高性能计算系统所基于的基于 PCIe 的下一代互连协议。

(2) CXL 内存模块 - DDR5 (CMM-DDR5):利用 CXL 技术的下一代 DDR5 内存模块,可提高 AI、云和高性能计算的带宽和性能。

(3) 基于内存中加速器的加速器 (AiMX):SK 海力士为使用 GDDR6-AiM 芯片的大型语言模型处理量身定制的专用加速卡。

(4) 企业和数据中心标准外形规格 (EDSFF):专门用于数据中心服务器的 SSD 外形规格的集合。

(5) 总拥有成本 (TCO):购置、运营和维护资产的全部成本,包括购买、能源和维护费用。

(6)注意层一种使模型能够评估输入数据的相关性,优先考虑更重要信息进行处理的机制。

(7)AI 推理:使用经过训练的 AI 模型分析实时数据以进行预测或任务完成的过程。

(8) 近内存处理 (NMP):一种在数据存储附近执行计算的技术,可减少延迟并提高 AI 和 HPC 等高带宽任务的性能。

(9) 间接内存访问一种计算寻址方法,其中一条指令提供内存位置的地址,其中包含所需数据或指令的实际地址。

(10) 基于对象的计算存储 (OCS)一种在存储系统中集成计算的存储架构,支持本地数据处理并最大限度地减少移动以提高分析效率。

(11) Checkpoint 卸载 SSD:在 AI 训练期间存储中间数据的存储解决方案,提高效率并缩短训练时间。

(12) HBM3E:第 5 代高带宽内存 (HBM),一种高价值、高性能的产品,通过将多个 DRAM 芯片与硅通孔 (TSV) 连接,彻底改变了数据处理速度。